OpenAI GPT OSS Modelle lokal auf GeForce RTX Grafikkarten laufen schnell (Bild © NVIDIA, OpenAI)

OpenAI GPT OSS Modelle lokal auf GeForce RTX Grafikkarten laufen schnell (Bild © NVIDIA, OpenAI)

Die neuen Modelle wurden mit einer Mixture-of-Experts-Architektur entwickelt und unterstützen komplexe Denkaufgaben, darunter Befehlsausführung, Tool-Nutzung und Kettengedanken-Problemlösung. Mit einer Kontextlänge von bis zu 131.072 Tokens setzt die gpt-oss-Familie auf Flexibilität lokaler Inferenz und eignet sich ideal für Anwendungen wie Websuche, Dokumentenanalyse und tiefgehende Forschung.

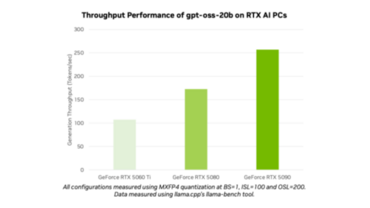

Die Modelle wurden auf NVIDIA H100-GPUs trainiert und nutzen das MXFP4-Format, das im Vergleich zu herkömmlichen FP16- oder INT-Formaten eine schnellere Inferenz mit weniger Hardware-Overhead ermöglicht. Die Leistung auf High-End-Consumer-Hardware ist bereits gut, denn bis zu 256 Token pro Sekunde sind auf einer GeForce RTX 5090 (Test) möglich, was Echtzeit-KI-Interaktion auf lokalen Systemen ermöglicht.

Nahtlose Integration mit Ollama und RTX-Hardware

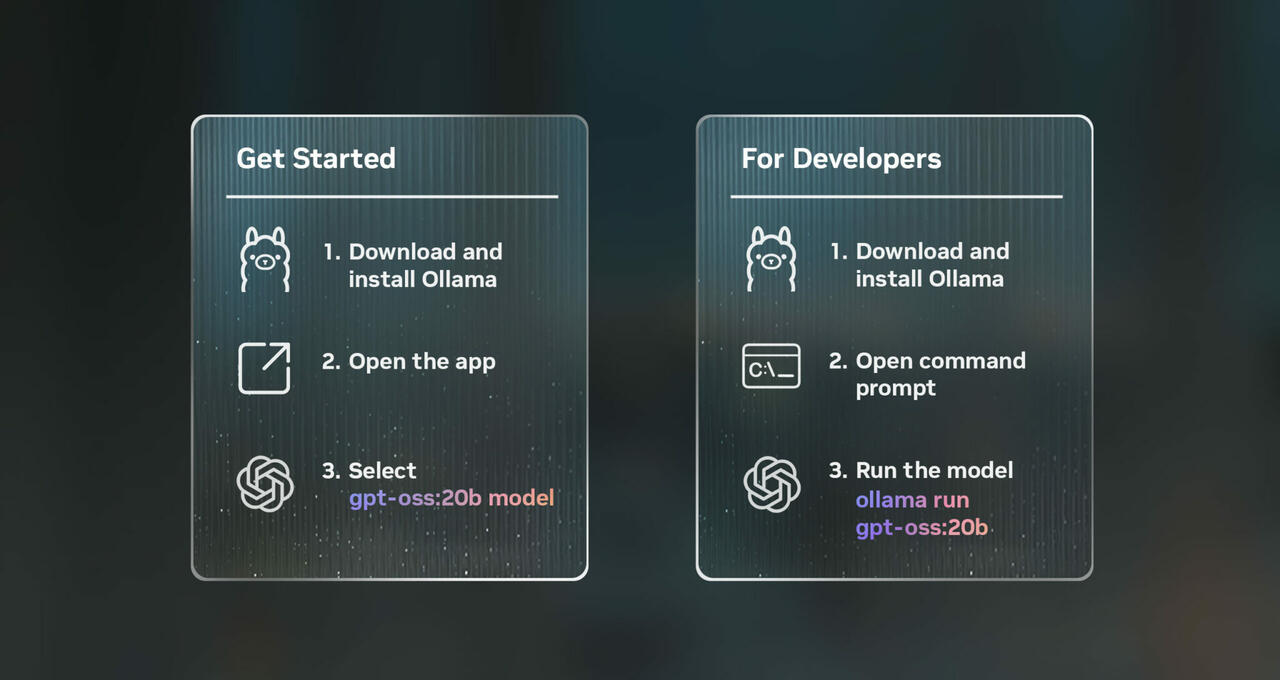

Benutzer können schnell mit der Ollama-Plattform loslegen, die jetzt die Open-Weight-Modelle von OpenAI vollständig unterstützt. Ollama läuft auf RTX-GPUs mit mindestens 24 GB VRAM, erfordert keine manuelle Optimierung und bietet eine optimierte Benutzererfahrung mit einer einfachen Benutzeroberfläche und sofortigem Modellzugriff. Zu den Funktionen gehören:

- PDF- und Klartext-Import direkt in Chats.

- Multimodale Unterstützung für Eingabeaufforderungen einschließlich Bildern (auf kompatiblen Modellen).

- Benutzerdefinierte Kontextlängen für große Dokumente oder längere Sitzungen.

Ollama bietet auch Befehlszeilentools und ein SDK für Entwickler, die lokale KI in ihre Anwendungen integrieren möchten.

Unterstützung des Ökosystems: llama.cpp, GGML und Microsoft Foundry Local

Über Ollama hinaus verbessert NVIDIA weiterhin die Kompatibilität mit Open-Source-KI. Das Unternehmen leistet einen aktiven Beitrag zu llama.cpp und der GGML-Tensor-Bibliothek, optimiert die GPU-Ausführung mit CUDA Graphs und reduziert den CPU-Overhead.

Für Windows-Entwickler bietet Microsoft AI Foundry Local eine weitere Möglichkeit, die gpt-oss-Modelle auf dem Gerät auszuführen. Dieses Framework, das sich derzeit in der öffentlichen Vorschau befindet, unterstützt die Integration über CLI, SDKs oder APIs und wird von ONNX Runtime mit TensorRT-Unterstützung in der Pipeline unterstützt. RTX-Nutzer können mit einem einfachen Terminalbefehl loslegen:

foundry model run gpt-oss-20b

Da sich die KI-Landschaft in Richtung lokaler Inferenz verschiebt, ist diese Zusammenarbeit zwischen NVIDIA und OpenAI ein guter Schritt in die richtige Richtung.

Die Modelle sind auch auf Huggingface zu finden: