NVIDIA TensorRT 10 Release (Bild © NVIDIA)

NVIDIA TensorRT 10 Release (Bild © NVIDIA)

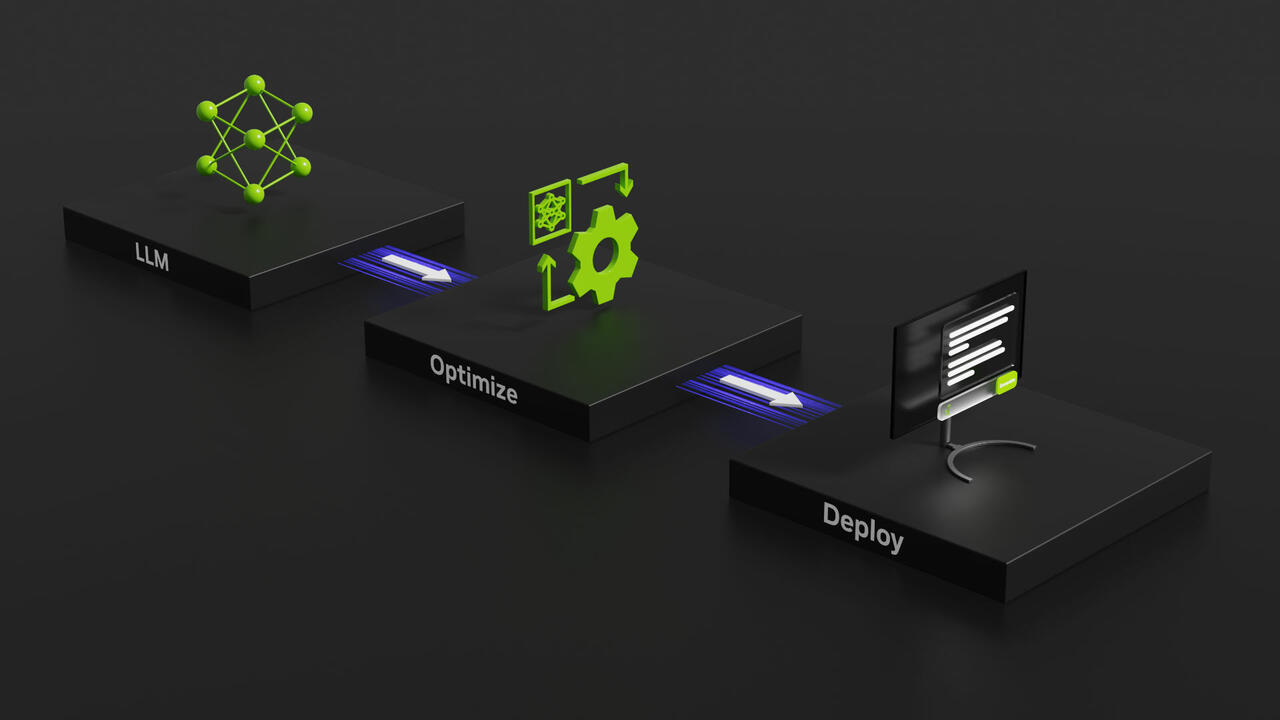

Das TensorRT Ökosystem wurde mit drei Hauptkomponenten aktualisiert: TensorRT 10.0, TensorRT-LLM 0.10 und TensorRT Model Optimizer 0.11. Jede Komponente bringt bedeutende Fortschritte mit sich und verbessert die Fähigkeiten und die Leistung von Deep Learning Modellen.

Hauptmerkmale von TensorRT 10

Mit TensorRT 10.0 wird die Unterstützung für Weight-Striped-Engines eingeführt, was eine effizientere Modellbereitstellung ermöglicht. Darüber hinaus enthält es Weight-Offload-Funktionen, die speziell für NVIDIA Grace Hopper Systeme entwickelt wurden und die Leistung für diese fortschrittlichen Rechenumgebungen optimieren. Das Update bringt auch Kompatibilität mit Python 3.12, so dass Entwickler die neuesten Python-Funktionen in ihren Deep Learning-Anwendungen nutzen können.

Erweiterungen in TensorRT-LLM 0.10

TensorRT-LLM 0.10 erweitert seine Unterstützung auf neue Modelle wie Llama3, Phi3 und Grok1. Diese Version integriert auch FP8 MoEs (Mixture of Experts) für eine verbesserte Modellleistung und führt Verbesserungen ein, die die API vereinfachen und konsolidieren, so dass es für Entwickler einfacher wird, große Sprachmodelle zu implementieren und zu verwalten.

Weiterentwicklungen in TensorRT Model Optimizer 0.11

Der TensorRT Model Optimizer 0.11 beinhaltet modernste Techniken wie Quantisierung und Sparsity, die für die Reduzierung der Modellkomplexität und die Verbesserung der Inferenz-Effizienz entscheidend sind. Diese Optimierungen ermöglichen es Entwicklern, kompaktere und effizientere Modelle einzusetzen, ohne die Leistung zu beeinträchtigen.

Mit diesen Updates erweitert NVIDIA die Grenzen des Machbaren im Bereich Deep Learning und gibt Entwicklern leistungsstarke Werkzeuge an die Hand, um KI-Anwendungen zu entwickeln und einzusetzen. TensorRT 10.0 ist ab sofort verfügbar und bietet eine robuste Plattform für die nächste Generation von KI-gesteuerten Lösungen.