Claude Code installieren (Bild © Anthropic)

Claude Code installieren (Bild © Anthropic)

Mindestanforderungen an die Hardware für lokale LLM

Für eine realistische Programmier-Erfahrung mit einem lokal gehosteten Modell sind mindestens 32 GB RAM erforderlich, entweder Apple Silicon Unified Memory oder herkömmlicher PC-RAM. Modelle sollten mit etwa 24B-Parametern beginnen, denn kleinere Modelle mit 16 GB neigen dazu, häufige Fehler zu produzieren und die Durchlaufzeit zu verlängern.

Empfohlene LLM-Modelle

| Model | Parameter | Vorzüge |

|---|---|---|

| devstral‑small‑2 | 24B | Solide Coding Leistung/Skills |

| qwen3‑coder | 30B | Bessere Coding Sills, passt in etwa in 32 GB |

| glm-4.7-flash:latest | 30B (quantized) | Geringe Latence und brauchbar |

Warum über die API von Anthropic hinausschauen?

Wenn man Claude Code mit dem offiziellen Opus 4.5-Endpunkt ausführt, verbraucht das schnell Credits. Dienste von Drittanbietern, die das Anthropic-API-Format nachahmen, können die Token-Kosten um bis zu 98 % senken. DeepSeek V3.2 kostet zum Beispiel etwa 0,28 $ pro Million Token, während lokale Ollama-Implementierungen keine Nutzungsgebühren verursachen. Die Abonnementstufen beginnen bei 3$ pro Monat für Zhipu GLM und 10$ pro Monat für MiniMax, was Teams eine vorhersehbare Budgetierung ermöglicht. Cusror ist auch nicht günstig und man muss recht schnell mehr Geld einwerfen, wenn man weiter mit Opus 4.5 arbeiten will. Es gibt aber Alternativen.

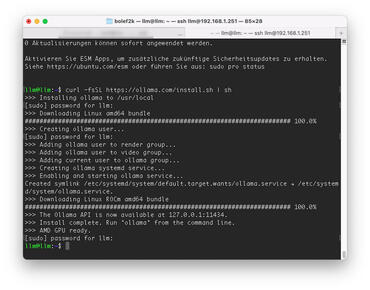

Option 1 – Ollama (lokal)

Wir haben einen ausführlichen Guide für Ollama lokale Installation.

- Einrichtungszeit: Leicht in unter etwa 5-10 Minuten

- Kosten: kostenlos, Open Source

- Am besten geeignet für: vollständige Privatsphäre, Offline-Arbeit

Installation

curl -fsSL https://ollama.com/install.sh | sh

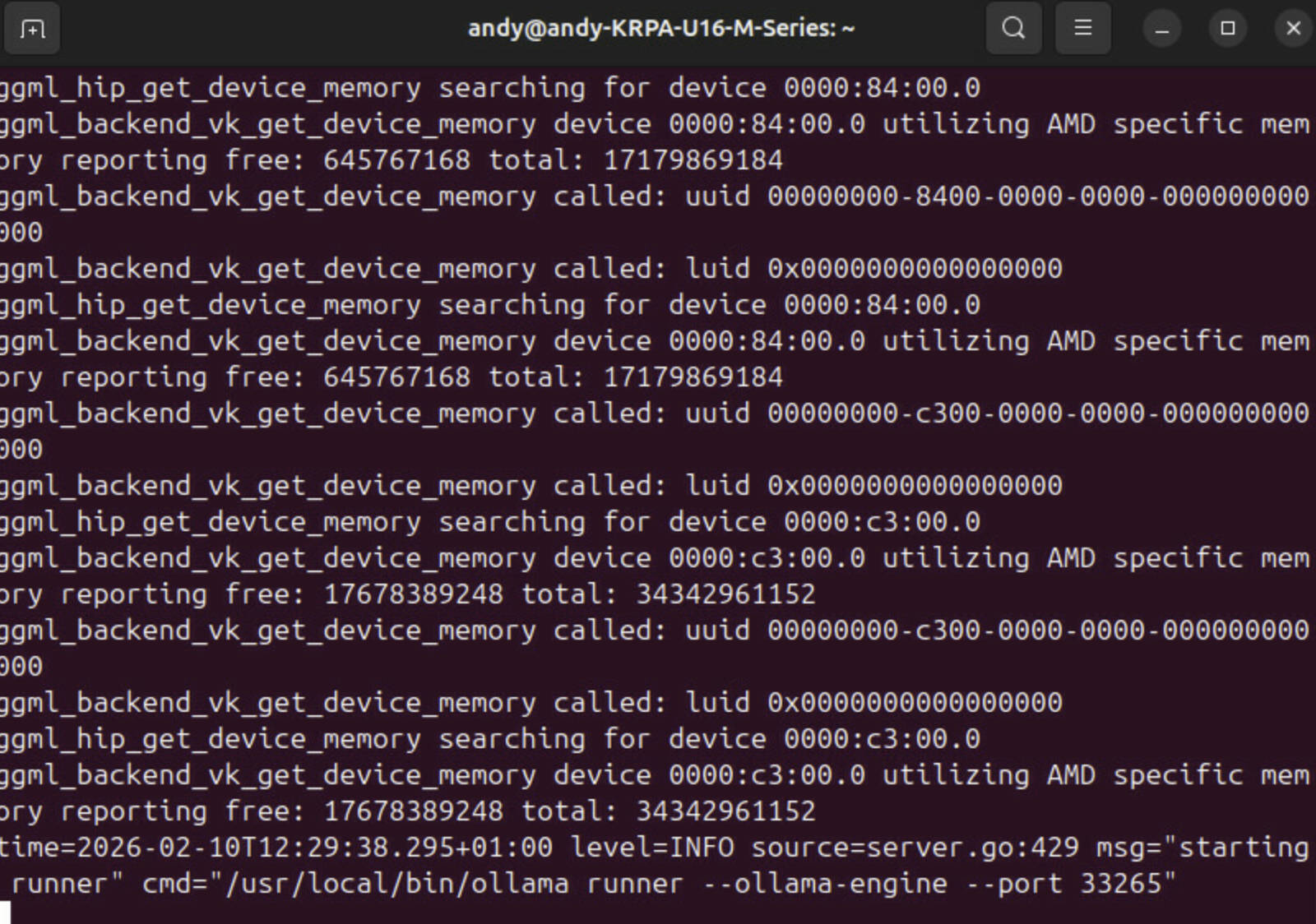

export OLLAMA_VULKAN=1

export OLLAMA_HOST=http://0.0.0.0:11434

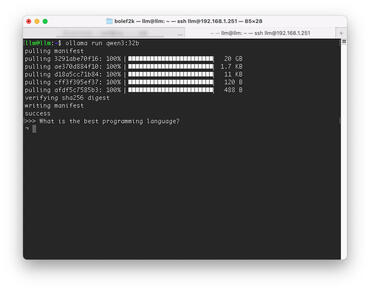

Modell-Download

ollama pull glm-4.7-flash:latest

ollama serve

Claude Code verbinden (Umgebungsvariablen)

export ANTHROPIC_AUTH_TOKEN="ollama"

export ANTHROPIC_BASE_URL="http://0.0.0.0:11434"

Ausführen:

claude --model glm-4.7-flash

Option 2 – llama.cpp + HuggingFace

- Einrichtungszeit: Dauert länger, etwa 15–20 Minuten

- Kosten: Kostenlos, Open Source

- Am besten geeignet für: Zugriff auf jedes HuggingFace-Modell, auch wenn das mit OLLAMA auch geht

Erstellen von llama.cpp

- macOS (Metal): cmake -DGGML_METAL=ON …

- Linux (CUDA): cmake -DGGML_CUDA=ON …

Starten des Servers (Beispiel mit qwen3 coder)

llama-server -hf bartowski/cerebras_Qwen3-Coder-REAP-25B-A3B-GGUF:Q4_K_M \

--alias „Qwen3-Coder-REAP-25B-A3B-GGUF“ --port 8000 \

--jinja --kv-unified --cache-type-k q8_0 --cache-type-v q8_0 \

--flash-attn on --batch-size 4096 --ubatch-size 1024 \

--ctx-size 64000

Link Claude Code

export ANTHROPIC_BASE_URL="http://localhost:8000"

claude --model Qwen3-Coder-REAP-25B-A3B-GGUF

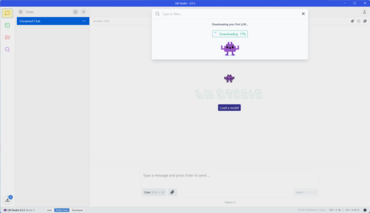

Option 3 – LM Studio

LM Studio gibt es auch für alle möglichen Systeme und auch mit einer eigenen GUI.

- Einrichtungszeit: Sehr easy, in unter 5 Minuten

- Kosten: Kostenlos

- Am besten geeignet für: GUI-gesteuerte Modellauswahl, Datenschutz

Lade den Desktop-Client von lmstudio.ai herunter oder installiere die CLI mit:

curl -fsSL https://lmstudio.ai/install.sh | bash

Wähle ein Modell über die Benutzeroberfläche aus oder führe lms chat → /download in der CLI aus. Starte den lokalen Server auf Port 1234:

lms server start -port 1234

Konfiguriere Claude Code:

export ANTHROPIC_BASE_URL="http://localhost:1234"

export ANTHROPIC_AUTH_TOKEN="lmstudio"

claude --model qwen/qwen3-coder-30b

Option 4 – Cloud-Anbieter-APIs

Für Teams, die eine detaillierte Kontrolle benötigen, setze die folgenden Umgebungsvariablen (oder bearbeite ~/.claude/settings.json).

OpenRouter (universeller Adapter)

export ANTHROPIC_BASE_URL="https://openrouter.ai/api"

export ANTHROPIC_AUTH_TOKEN="YOUR_OPENROUTER_KEY"

export ANTHROPIC_MODEL="openai/gpt-oss-120b:free"

MiniMax (kostengünstig und hochwertig)

export ANTHROPIC_BASE_URL="https://openrouter.ai/api"

export ANTHROPIC_AUTH_TOKEN="YOUR_MINIMAX_KEY"

export ANTHROPIC_MODEL="MiniMax-M2.1"

Ähnliche Blöcke funktionieren für GLM, DeepSeek, Kimi und andere Anbieter, nur die Basis-URL, das Authentifizierungstoken und der Modellname ändern sich.

Claude Code in a Nut Shell

Der Editor ist jetzt ein vielseitiges Frontend, das auf lokale Modelle, von der Community gehostete Server oder kommerzielle Cloud-APIs zugreifen kann. Nutzer mit einem 32-GB-Mac können mit devstral-small-2 eine ordentliche Leistung erzielen, während GPU-reiche Umgebungen wie Nvidia DGX Spark das volle Potenzial größerer Modelle mit mehr als 30 B ausschöpfen. Für datenschutzkritische Workloads bieten Ollama und LM Studio Offline-Lösungen; für Geschwindigkeit und Skalierbarkeit liefern Cloud-Optionen wie Ollama Cloud, MiniMax oder OpenRouter hochwertige Ergebnisse zu einem Bruchteil des Preises von Anthropic.