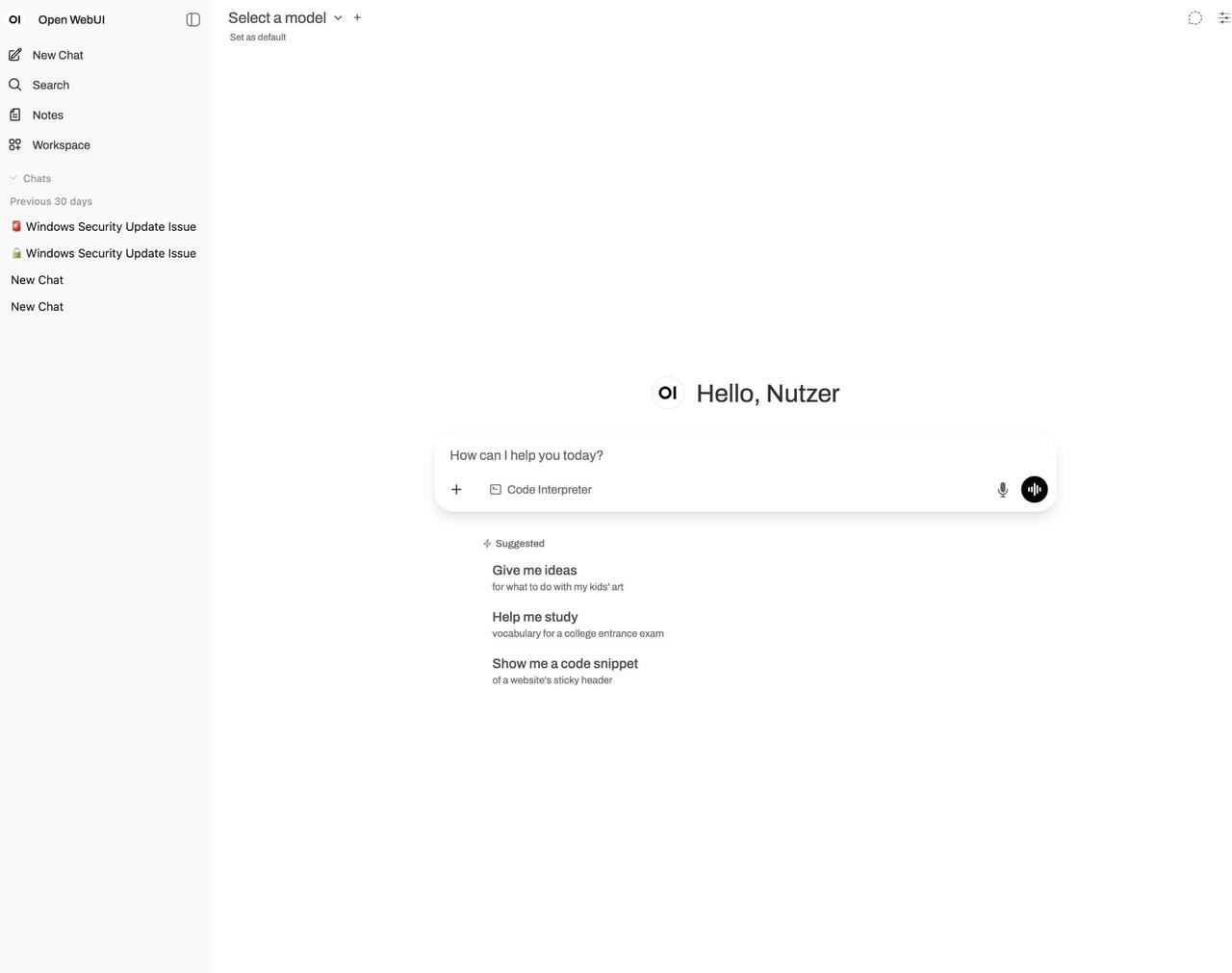

Open WebUI installieren (Bild © PCMasters.de)

Open WebUI installieren (Bild © PCMasters.de)

Anforderungen und Optionen

- Betrachtete Plattformen: Ubuntu 24.04, Debian 12.

- Mindestanforderungen an die Hardware: 16 GB RAM, ~50 GB freier Speicherplatz. Eine Grafikkarte ist optional. Moderne CPUs mit AVX-512 und DDR5 helfen beim Durchsatz (lscpu | grep -o avx512 und dmidecode -t memory | grep -i DDR5).

- Topologien: **Einzelner Host mit Ollama und Open WebUI auf demselben Server oder geteilter Host mit Ollama auf einem Server, WebUI auf einem anderen - erfordert Netzwerkzugriff auf den Ollama-API-Port.

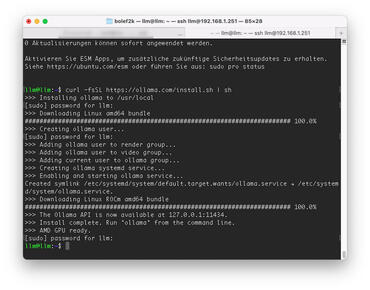

Schritt 1 – Ollama installieren und ausführen

Der einfachste Weg ist es, das Installations-Script zu nutzen:

bash

curl -fsSL https://ollama.com/install.sh | sh

Manueller Pfad (große Ebene):

- 1.Grafikkarten-Treiber (optional): Überprüfe NVIDIA CUDA mit nvidia-smi; installiere bei Bedarf die entsprechenden nvidia-kernel-open-545 und cuda-drivers-545.

- 2.AMD-Unterstützung: Lade den ROCm-fähigen Ollama-Tarball herunter und extrahiere ihn nach /usr.

- 3.Laufzeit: Lade den Standard-Ollama-Tarball herunter, entpacke ihn in /usrund erstelle einen gesperrten Dienstnutzer (ollama).

- 4.systemd-Dienst: Erstelle /etc/systemd/system/ollama.service, führe ExecStart=/usr/bin/ollama serve als Nutzer/Gruppe ollamaaus.

- Standardbindung: 127.0.0.1:11434 (nur lokal).

- Netzwerkzugriff (optional): Stelle Environment=„OLLAMA_HOST=0.0.0.0:11434“ und öffne den Port in der Firewall.

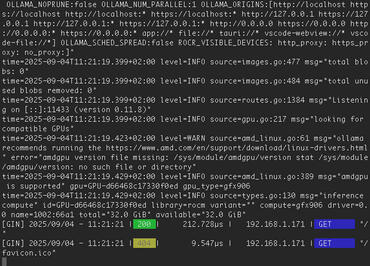

Aktivieren und überprüfen, ob Ollama als Dienst funktioniert:

bash

sudo systemctl daemon-reload

sudo systemctl enable --now ollama

systemctl status ollama

ollama --version

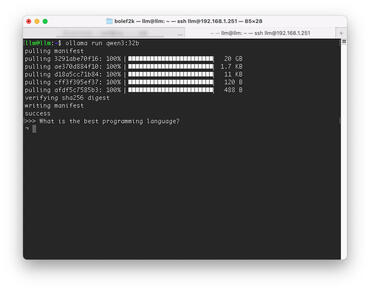

Schneller Test auf dem System unter Verwendung eines Modells:

bash

ollama run qwen3

# Modell später entfernen:

ollama rm <modellname>

Die verfügbaren Modelle, wie qwen3 sind auf der OLLAMA-Seite zu finden und können dort auch überprüft werden.

</modellname></section></div>

Schritt 2 – Open WebUI installieren (manuell oder Docker)

Open WebUI bietet ein Chat-Frontend und kommuniziert mit der Ollama-API.

Die manuelle Installation sieht wie folgt aus. Installiere die Voraussetzungen und klone:

bash

sudo apt update && sudo apt install -y npm python3-pip python3-venv git

git clone https://github.com/open-webui/open-webui.git

cd open-webui && cp -RPp .env.example .env

Ollama-Endpunkt stellen:

- Gleicher Host: localhost:11434 in .envbeibehalten.

-

Geteilter Host: durch http://

:11434ersetzen.

Frontend erstellen und Backend vorbereiten:

bash

npm i && npm run build

cd backend

python3 -m venv venv && source venv/bin/activate

pip install -r requirements.txt -U

bash start.sh

Der Standard-WebUI-Port ist 8080 → Zugriff unter http://

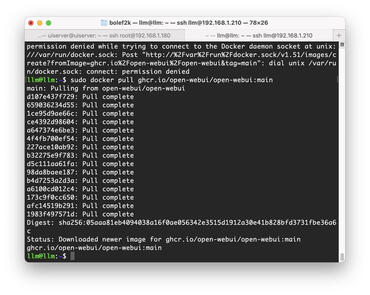

Docker installieren

Gleicher Host wie Ollama:

bash

sudo docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway \

-v open-webui:/app/backend/data --name open-webui --restart always \

ghcr.io/open-webui/open-webui:main

Separater Host: Stell sicher, dass der Ollama-Server 11434 freigibt und ordentlich durch eine Firewall geschützt ist, dann:

bash

sudo docker run -d -p 3000:8080 \

-e OLLAMA_BASE_URL=http://<ollama-host>:11434 \

-v open-webui:/app/backend/data --name open-webui --restart always \

ghcr.io/open-webui/open-webui:main

Der Standard-WebUI-Port für Docker ist 3000 → http://<server>:3000.

</server></ollama-host></server></ollama-host></section></div>

Schritt 3 – Firewall-Ports öffnen

Überprüfe die Listener mit:

bash

sudo ss -tulpn | grep LISTEN

# z. B. 127.0.0.1:11434 (Ollama), 0.0.0.0:8080 oder 3000 (WebUI)

Mit ufw auf Ubuntu:

bash

sudo ufw status

sudo ufw allow proto tcp to any port 8080 # manuelle WebUI

sudo ufw allow proto tcp to any port 3000 # Docker WebUI

# Wenn Ollama extern verfügbar gemacht wird:

sudo ufw allow proto tcp to any port 11434

Schritt 4 – Modelle hinzufügen und mit dem Chatten anfangen

Erste Anmeldung: Erstelle den ersten Admin-Nutzer in Open WebUI. Modelle aus der Benutzeroberfläche abrufen:

- Admin-Bereich → Einstellungen → Modelle → Herunterladen, z. B. llama3 oder DeepSeek.

Fehlerbehebung: Wenn die Benutzeroberfläche meldet, dass sie Ollama nicht erreichen kann, vergewissere dich, dass der Dienst aktiv ist und die API-URL mit deiner Topologie übereinstimmt.

Chatten: Wähle das Modell im Composer aus; füge mehrere Modelle hinzu, um parallele Antworten zu bekommen.