GPT OSS 120B KI Modelle mit Ryzen AI MAX+ und Radeon GPUs nutzen (Bild © AMD)

GPT OSS 120B KI Modelle mit Ryzen AI MAX+ und Radeon GPUs nutzen (Bild © AMD)

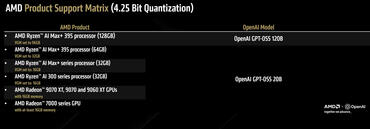

AMD betonte, dass vor allem die Ryzen AI MAX+ 395 APU ist der erste und einzige Chip für Endverbraucher, der das riesige GPT-OSS 120B-Modell ohne externe Beschleunigung nativ ausführen kann. Diese Modelle, die als offene Nachfolger von GPT-2 fungieren, sind ein großer Schritt in der Entwicklung von zugänglicher, groß angelegter KI. GPT-OSS 120B braucht besonders Hardware mit viel Speicherbandbreite und -kapazität.

Das 120B-Modell wurde für lokale Inferenz mit dem GGML-Framework in das MXFP4-Format konvertiert und braucht etwa 61 GB VRAM. Die AMD Ryzen AI MAX+ 395 mit 128 GB einheitlichem Speicher und 96 GB dediziertem Grafikspeicher erfüllt diese Anforderung und unterstützt außerdem das Model Context Protocol (MCP) vollständig. Dieses Protokoll verbessert die Kontinuität und Reaktionsfähigkeit bei längeren Inferenz-Workloads.

Nutzer, die das GPT-OSS 120B-Modell auf Ryzen AI MAX+ ausführen, können bis zu 30 Tokens pro Sekunde erwarten. Es ist eine praktische Leistungsstufe für Workloads mit der Generierung langer Inhalte, Forschungsagenten oder Code-Analysen. AMD bestätigt, dass diese Funktion mit den neuesten GPU-Treibern freigeschaltet ist: AMD Software Adrenalin Edition 25.8.1 WHQL oder neuer.

Für Entwickler und Enthusiasten, die sich für das kleinere GPT-OSS 20B-Modell interessieren, bieten die AMD Radeon RX 9070 XT 16 GB und andere GPUs mit mindestens 16 GB Speicher ausreichend Leistung. Diese Konfigurationen bieten einen schnellen Token-Durchsatz und eine kurze Zeit bis zum ersten Token (TTFT), was besonders in rechenintensiven Szenarien bei der Bereitstellung von MCP-fähigen Workflows von Vorteil ist.

GPT-OSS 120B- und 20B-Modelle auf AMD Ryzen KI-Prozessoren und Radeon Grafikkarten

Die GPT-OSS-Modelle von OpenAI werden über LM Studio unterstützt, eine leichtgewichtige Plattform für lokale LLM-Inferenz. AMD-Nutzer können diese Modelle bereitstellen, indem sie die neuesten Treiber herunterladen, die Grafikkarteneinstellungen anpassen (falls zutreffend) und über die Registerkarte „Discover“ von LM Studio die entsprechende GPT-OSS-Variante laden.

- 1.Lade die AMD Software: Adrenalin Edition 25.8.1 WHQL Treiber oder höher runter und installiere sie. Bitte beachte, dass die Leistung und der Support bei älteren Treibern eingeschränkt sein oder ganz fehlen können.

- 2.Wenn du einen AMD Ryzen™ AI-basierten Rechner hast, klicke mit der rechten Maustaste auf den Desktop > AMD Software: Adrenalin™ Edition > Registerkarte „Leistung“ > Registerkarte „Tuning“ > „Variabler Grafikspeicher“ > stelle VGM bitte gemäß der unten angegebenen Spezifikationstabelle ein. Wenn du eine AMD Radeon™-Grafikkarte hast, kannst du diesen Schritt überspringen und fortfahren.

- 3.Lade LM Studio herunter und installiere es.

- 4.Überspringe die Onboarding-Phase.

- 5.Gehe zur Registerkarte „Entdecken“ (Lupe).

- 6.Such nach „gpt-oss“. Du solltest links eine Option mit dem Präfix „lm studio community“ sehen. Wähl entweder die 20B- oder die 120B-Variante aus (je nachdem, welche deinem Produkt in der unten angegebenen Matrix entspricht). Klick auf „Herunterladen“.

- 7.Geh zur Registerkarte „Chat“.

- 8.Klick oben auf das Dropdown-Menü und wähl das OpenAI-Modell aus. Klick unbedingt auf „Parameter manuell laden“.

- 9.Schiebe den Schieberegler „GPU-Auslagerung“ ganz nach rechts auf MAX. Aktiviere das Kontrollkästchen „Einstellungen speichern“.

- 10.Klicke auf „Laden“. Wenn du das 120B-Modell verwendest, kann es eine Weile dauern und die Ladeleiste scheint möglicherweise hängen zu bleiben (die Lesegeschwindigkeit der meisten SSDs sinkt nach einem Burst, und dieses Modell ist sehr groß, um es in den Arbeitsspeicher zu laden!

- 11.Beginne mit der Eingabeaufforderung!

Die von AMD bereitgestellte Support-Liste umfasst Ryzen AI-Chips der Serie 300 für GPT-OSS 20B und Ryzen AI MAX+ 395 exklusiv für 120B. GPUs der Serien Radeon RX 7000 und RX 9000 sowie Radeon AI PRO R9000-Varianten unterstützen ebenfalls das 20B-Modell, wenn sie mit ausreichend Speicher ausgestattet sind.