NVIDIA Blackwell Ultra (Bild © NVIDIA)

NVIDIA Blackwell Ultra (Bild © NVIDIA)

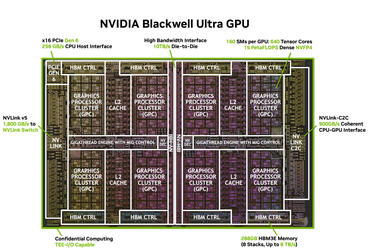

Dual-Die-Compute-Fabric und HBM3E mit maximaler Bandbreite

Blackwell Ultra verteilt seine Rechenleistung auf zwei große Dies, die über NV-HBI verbunden sind, eine 10 TB/s schnelle Die-to-Die-Fabric, die wie ein einziges logisches Gerät funktioniert. Die Konfiguration umfasst 160 Streaming-Multiprozessoren (SMs), dazu extrem großen 288 GB HBM3E Speicher mit einer Gesamtbandbreite von bis zu 8 TB/s versorgt werden. Die Tensor-Cores der 5. Generation von NVIDIA sind auf NVFP4 abgestimmt, das Präzisionsformat des Unternehmens, das für die Beschleunigung der Transformer-Inferenz bei gleichbleibender Genauigkeit optimiert ist.

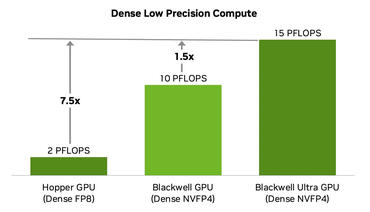

Auch die Spezialfunktionen wurden deutlich verbessert und verdoppeln den Durchsatz für transzendentale Operationen, die in Aufmerksamkeits-Layern verwendet werden. In der Praxis senkt dies die Softmax-Latenz und beschleunigt das End-to-End-Reasoning, was sich in einer größeren Token-Pro-Sekunde-Rate bei Bereitstellungs-Workloads niederschlägt. NVIDIA gibt die Gesamtrechendichte in NVFP4 mit dem ca. 1,5-fachen des Standard-Blackwell an, ein Gewinn, der direkt auf Großserientrainings und skalierte Inferenz bei knappen Strombudgets abzielt.

| Feature | Hopper | Blackwell | Blackwell Ultra |

|---|---|---|---|

| Fertigungsprozess | TSMC 4N | TSMC 4NP | TSMC 4NP |

| Transistoren | 80B | 208B | 208B |

| Dies pro GPU | 1 | 2 | 2 |

| NVFP4 dichte | spärliche Leistung | – | 10 | 20 PetaFLOPS | 15 | 20 PetaFLOPS |

| FP8 dichte | spärliche Leistung | 2 | 4 PetaFLOPS | 5 | 10 PetaFLOPS | 5 | 10 PetaFLOPS |

| Beschleunigung der Aufmerksamkeit (SFU EX2) |

4,5 TeraExponentials/s | 5 TeraExponentials/s | 10,7 TeraExponentials/s |

| Maximale HBM-Kapazität | 80 GB HBM (H100) 141 GB HBM3E (H200) |

192 GB HBM3E | 288 GB HBM3E |

| Maximale HBM-Bandbreite | 3,35 TB/s (H100) 4,8 TB/s (H200) |

8 TB/s | 8 TB/s |

| NVLink-Bandbreite | 900 GB/s | 1.800 GB/s | 1.800 GB/s |

| Maximale Leistung (TGP) | Bis zu 700 W | Bis zu 1.200 W | Bis zu 1.400 W |

Flüssigkeitsgekühlte Racks mit 1.400 W

Mit einer TDP von 1.400 W setzt Blackwell Ultra eine Flüssigkeitskühlung auf Rack-Ebene voraus. Die Referenzarchitektur von NVIDIA, die GB300 NVL72, kombiniert Grace Blackwell Ultra Superchips zu dichten, flüssigkeitsgekühlten Racks, die das Unternehmen für einen Durchsatz im Exascale-Bereich FP4 positioniert. Im Vergleich zu früheren HGX-Plattformen betont NVIDIA Verbesserungen beim Durchsatz pro Megawatt, einer Kennzahl, die für Betreiber, die an Leistungs- und Platzgrenzen stoßen, immer wichtiger wird.

Gemeinsames Design von Software und Hardware

NVIDIA kombiniert den Siliziumchip mit der Kontinuität von CUDA und einem für die Blackwell Ultra-Topologie optimierten Stack: TensorRT-LLM, Dynamo-Scheduling und präzisionsbewusste Modelloptimierer nutzen NVFP4 und die Dual-Die-Struktur, um eine größere Auslastung zu erzielen und die Kosten pro Token zu senken. Für Multi-Tenant-Bereitstellungen bietet Blackwell Ultra fortschrittliche MIG-Partitionierung, TEE-I/O-Confidential Computing, Hardware-Dekomprimierung und erweiterte NVLink-Fabrics, um Modelle und Aktivierungen effizienter zwischen den Knoten zu verschieben.

Was bedeutet das für KI-Fabriken?

Das Rezept von Blackwell Ultra: mehr Speicher auf dem Chip, schnellere Host-I/O über PCIe Gen6 und NVFP4-zentrierte Beschleunigung. Damit richtet sich das Produkt an Betreiber, die sowohl ihre Inferenzfarmen als auch ihre Trainingscluster skalieren wollen. Durch die Konsolidierung der Rechenleistung auf zwei eng gekoppelten Dies und die Ausnutzung der HBM3E-Bandbreite bis an die praktische Grenze optimiert NVIDIA den Betrieb für hohe Dichte, Stabilität und Energieeffizienz, wo die Anzahl der Tokens pro Sekunde pro Rack und der Durchsatz pro MW entscheidend für die Wirtschaftlichkeit sind.

Während NVIDIA sich auf die Umstellung der breiteren Roadmap auf „Rubin“ vorbereitet, wird Blackwell Ultra effektiv die Krönung dieser Generation, die dafür ausgelegt ist, LLM-Dienste und das Training großer Batches auf einer steilen Effizienzkurve zu halten, während Rechenzentren mit Strom- und Kühlungsbeschränkungen zu kämpfen haben.