Intel LLM Scaler 1.0 für Arc Pro (Bild © Intel)

Intel LLM Scaler 1.0 für Arc Pro (Bild © Intel)

Neu im LLM Scaler v1.0

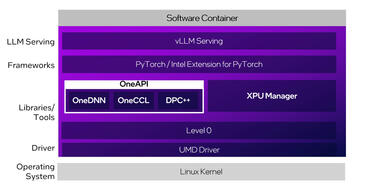

Die erste Version kommt als containerisierter Stack, der die Bereitstellung standardisiert und eine breite Palette an Optimierungen für vLLM, Intels Inferenzserver mit hohem Durchsatz, bietet:

- Durchsatz bei langen Kontexten: Gezielte TPOP-Verbesserungen steigern die Leistung bei einer Sequenzlänge von 40K auf 32B KPI-Modellen um das 1,8-fache und bei 40K auf 70B KPI-Modellen um das 4,2-fache.

- Allgemeiner Durchsatz: Etwa 10 % mehr Output-Token für 8B–32B KPI-Modelle im Vergleich zum vorherigen Rückgang.

- Speichereffizienz: By-Layer-Online-Quantisierung reduziert die Working-Set-Größe, um größere Modelle oder längere Kontexte pro GPU zu ermöglichen.

- Parallelität und Kernel (experimentell): Pipeline-Parallelität, torch.compile und spekulative Decodierung stehen für erste Tests zur Verfügung.

- Modellabdeckung: Integrierte Unterstützung für Embedding- und Re-Rank-Modelle, verbesserte multimodale Verarbeitung, automatische Erkennung der maximalen Länge und Datenparallelität erweitern die Anwendungsfälle und vereinfachen die Konfiguration.

Über vLLM hinaus ermöglicht der Container OneCCL-Benchmarking und integriert XPU Manager-Steuerelemente für Leistung, Firmware-Updates, Diagnose und Speicherbandbreitenüberwachung.

Intel positioniert LLM Scaler v1.0 als einen „Inference Optimized”-Container, der bei der Skalierung über mehrere Arc Pro-GPUs mit aktivierten PCIe-Peer-to-Peer-Übertragungen eine bis zu 80 % höhere Leistung liefern kann. Der Stack ist für Linux optimiert, wobei der Schwerpunkt auf einem konsistenten Durchsatz unter langen Kontextfenstern und Multi-GPU-Orchestrierung liegt.

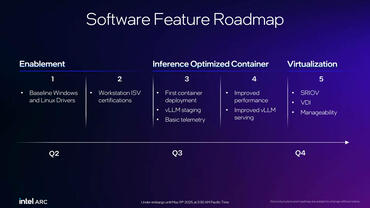

Gemäß der Roadmap von Intel wird dieser v1.0-Release später im 3. Quartal durch einen gehärteten Container mit weiteren Leistungsverbesserungen und verbessertem vLLM-Service ergänzt. Ein Release mit vollem Funktionsumfang ist für das 4. Quartal geplant und rundet das erste Jahr von Project Battlematrix mit Arc Pro ab.