Supermicro Blackwell Server (Bild © Supermicro)

Supermicro Blackwell Server (Bild © Supermicro)

Durch die Verlagerung der Netzwerk- und Servicepunkte in den Kaltgang reduziert das Front-I/O-Layout die Rack-Zeit und die Kabelkomplexität und verbessert gleichzeitig das Luftstrommanagement. Supermicro kombiniert dies mit seiner DLC-2-Direktflüssigkeitskühlungsarchitektur, die auf KI-optimierte Rechenzentren ausgerichtet ist, die strengere thermische Vorgaben und eine vorhersehbare Akustik erfordern.

- Energie und Wasser: Bis zu 40 % Energieeinsparungen im Rechenzentrum; Warmwasserkühlung auf 45 °C reduziert oder eliminiert Kältemaschinen und senkt den Wasserverbrauch um bis zu 40 %.

- Wärmerückgewinnung: Bis zu 98 % der Systemwärme wird über Flüssigkeitskreisläufe an CPUs, GPUs, DIMMs, PCIe-Switches, VRMs und Netzteilen absorbiert.

- Akustik: Der Betrieb mit ~50 dB ermöglicht leisere Einrichtungen und gemischt genutzte Räume.

Beide Systeme basieren auf NVIDIA HGX B200 (8 GPUs) pro Knoten mit NVLink Gen5, das eine GPU-zu-GPU-Bandbreite von 1,8 TB/s und bis zu 1,4 TB HBM3e pro Server bietet. Die Plattform ist für die NVIDIA Quantum-2 InfiniBand- und Spectrum-X Ethernet-Fabrics ausgelegt und bringt Netzwerkcontroller an die Frontplatte:

- 8× Single-Port 400G NVIDIA ConnectX-7 NICs oder NVIDIA BlueField-3 SuperNICs

- 2× Dual-Port NVIDIA BlueField-3 DPUs für Offload und sicheres Host-Management

Diese Wartungsfreundlichkeit an der Vorderseite erstreckt sich auf Speicherplätze und Verwaltungsports, was das Verschieben, Hinzufügen und Ändern von Cold Aisles in Clustern mit hoher Dichte vereinfacht.

CPU, Arbeitsspeicher und Speicher für KI-Pipelines optimiert

Um die Blackwell-GPUs mit Daten zu versorgen, unterstützen die Knoten Dual-Socket-Intel-Xeon-6-Prozessoren (Serie 6700) mit bis zu 350 W pro CPU. Die Arbeitsspeicherkapazität und Bandbreite lassen sich mit 32 DDR5-RDIMM-Steckplätzen skalieren:

- Bis zu 8 TB bei 5200 MT/s oder 4 TB bei 6400 MT/s

- 8× Hot-Swap-fähige E1.S NVMe-Laufwerksschächte für Scratch-/Cache-Ebenen mit hoher IOPS-Leistung

- 2× M.2 NVMe-Boot-Geräte

Der große Systemspeicher hilft, CPU-GPU-Engpässe zu verringern, beschleunigt die Datenbereitstellung und steigert den Durchsatz bei mehreren Jobs in virtualisierten und containerisierten KI-Umgebungen. Supermicro weist darauf hin, dass die Produktreihe in Konfigurationen mit zwei Front-I/O und sechs Rear-I/O HGX B200 erhältlich ist, um den standortspezifischen Anforderungen an CPUs, Speicherplatz, Fabrics und Kühlung gerecht zu werden.

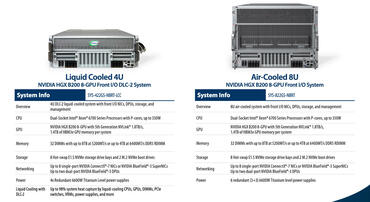

4U DLC-2 flüssigkeitsgekühlt, Front-I/O

- Anwendungsfall: dicht gepackte KI-Fabriken, die auf Tausende von Knoten skalierbar sind

- Kühlung: DLC-2 mit Warmwasserkreisläufen; Frontwartung für NICs, DPUs, Speicher und Management

- GPU: HGX B200 (8 GPUs, jeweils 180 GB HBM3e) mit NVLink Gen5

- CPU: zwei Intel Xeon 6 (6700 Serie) mit bis zu 350 W

- RAM: 32 DIMMs, bis zu 8 TB/5200 oder 4 TB/6400

- Speicher: 8× E1.S NVMe Hot-Swap + 2× M.2 NVMe Boot

- Netzwerk: 8× 400G-NICs + 2× BlueField-3-DPUs von vorne zugänglich

8U luftgekühlt, Front-I/O

- Anwendungsfall: Einrichtungen ohne Flüssigkeitsinfrastruktur

- Formfaktor: kompaktes 8U mit einem flacheren CPU-Einschub und einem 6U-GPU-Einschub in voller Höhe für maximale Luftkühlungsleistung

- Kernspezifikationen: entspricht der Rechenleistung, dem Arbeitsspeicher, dem Speicher und der Netzwerkleistung der 4U-Plattform – mit Wartungsfreundlichkeit an der Vorderseite für den Betrieb in Kaltgängen

Die NVIDIA Blackwell-Plattform ist für LLM-Anwendungen der nächsten Generation ausgelegt und ermöglicht eine bis zu 15-mal schnellere Echtzeit-Inferenz und ein bis zu 3-mal schnelleres Training im Vergleich zu Hopper-basierten GPUs. Sie verfügt über NVLink Gen5-Verbindungen und HBM3e-Kapazität zur Skalierung größerer Kontextfenster und Multi-Modell-Pipelines.