MSI GeForce RTX 5090 32G Gaming Trio OC ARGB Beleuchtung 2 (Bild © PCMasters.de)

MSI GeForce RTX 5090 32G Gaming Trio OC ARGB Beleuchtung 2 (Bild © PCMasters.de)

Klassische Benchmarks genügen dabei nicht mehr; entscheidend ist eine Architektur, die Reserven aufweist und sich zugleich feingranular anpassen lässt, damit jede Aufgabe innerhalb ihres Zeitfensters abgeschlossen wird.

Skalierbare Architektur als Basis

Leistung beginnt auf der Ebene der Plattform. Mehrkernprozessoren harmonieren heute mit ultrabreiten Speicherschnittstellen und PCIe-5.0-Verbindungen, wodurch Datenpakete mit minimaler Latenz zu GPU-Beschleunigern oder NVMe-Arrays strömen. Die folgende Übersicht führt zentrale Stellschrauben auf, die jede Workstation oder jeder Server berücksichtigen muss, wenn Durchsatz und Effizienz gleichermaßen Priorität erhalten:

- Anzahl physischer Kerne in Relation zur geplanten Thread-Dichte

- Taktfrequenz und Turbo-Spielraum unter anhaltender Last

- Cache-Struktur - insbesondere großzügige L3-Pools für datenintensive Algorithmen

- Speicherkanäle und deren Ausbaustufen, um Engpässe auszuschließen

- I/O-Lanes für GPUs, Netzwerkkarten und schnelle Massenspeicher

- Thermisches Design für konstante Taktraten auch bei langer Volllast

Beispielhafter Hardware-Pool für kreative Workloads

Ein praxisnahes Szenario illustriert, wie unterschiedliche Komponenten zusammenwirken. Ein Filmstudio kombiniert einen 32-Kern-Prozessor mit zwei High-End-Grafikkarten, 128 GB DDR5-6400-RAM und einem RAID-Verbund aus PCIe-5.0-SSDs. Die Render-Pipeline verteilt Frames parallel, während der CPU-Cache Textur-Daten lokal vorhält und der Systemspeicher Zwischenergebnisse puffert. Ähnliche Konfigurationen detachieren sich zunehmend aus dem engen Segment "Rendering Rig" und fließen in Consumer-nahe Geräte ein. So hält der Systemintegrator MIFCOM leistungsstarke Gaming-PCs parat, die mit vergleichbaren Leistungsreserven ebenfalls VR-Produktionen oder Echtzeit-Compositing schultern.

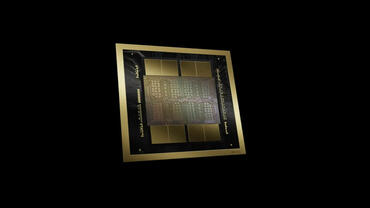

Blackwell - GPU-Innovationssprung 2024

Von 2024 bis 2025 erlebte das Thema rohe Rechenkraft eine wegweisende Neuerung: NVIDIAs Blackwell-Architektur. Das Flaggschiff-Silizium vereint zwei GPU-Dies mithilfe eines 10 TB/s-Interconnects zu einer logisch einheitlichen Grafikeinheit und packt rund 208 Milliarden Transistoren in einen Chipverbund. Gegenüber der Vorgänger-Generation Hopper steigt nicht nur die FP64-Leistung für wissenschaftliche Simulationen; eine zweite Generation des Transformer-Engines beschleunigt auch LLM-Inference mit 4-Bit-Präzision. Modelle mit bis zu zehn Billionen Parametern lassen sich dadurch in Echtzeit bedienen - ein Leistungssprung, der Serverfarmen verkleinert und Edge-Deployments erlaubt.

Die Architektur verdeutlicht, wie eng Energieeffizienz und Spitzenleistung inzwischen verknüpft sind. Trotz gewaltiger Transistor-Zahl sinkt der Bedarf an Rechenzentren, da Blackwell-Nodes rechnerisch mehr Aufgaben pro Watt erledigen. Das Ergebnis: geringere Betriebskosten und Spielraum für neue Anwendungsfälle - vom autonomen Fahrzeugtraining bis zur Klimamodellierung in Regionalbüros.

Intelligentes Ressourcen-Management

Containerisierte Workloads verteilen sich heute dynamisch über heterogene Cluster, um Spitzenlasten ohne Leerlaufzeiten abzufedern. Moderne Orchestrierungslösungen wie Kubernetes integrieren Hardware-Telemetrie, messen Kernfrequenzen, Speicherbandbreite und GPU-Auslastung in Echtzeit und verschieben Pods darauf abgestimmt. Selbst datenbankintensive Microservices profitieren, weil der Scheduler transiente I/O-Peaks antizipiert und Instanzen gezielt auf knoteneigene NVMe-Pools verschiebt. Dieses symbiotische Zusammenspiel aus Software-Schicht und Silicon schafft reibungslose Skalierung, reduziert Warteschlangen und stellt durchgängig konstante Antwortzeiten sicher. Dadurch entfällt kostspieliges Überprovisionieren und Betriebsteams gewinnen Planungsspielraum für neue Dienste und Releases.

Zukunftssichere Performance mit Weitblick

"Ausreichend Leistung" bedeutet heute, Spielräume für morgen einzuplanen. CPU-Cores, Cache-Größen und GPU-Beschleuniger wachsen zwar in regelmäßigen Zyklen, doch echte Zukunftssicherheit entsteht erst, wenn Plattform, Kühlung und Energieversorgung darauf ausgelegt sind, kommende Generationen ohne grundlegende Umbauten aufzunehmen. Wer eine solche Basis schafft, verwandelt Rechenkraft in eine flexible Ressource - jederzeit bereit, neue Algorithmen, höhere Auflösungen oder komplexere Modelle aufzunehmen, ohne Abstriche bei Qualität oder Durchlaufzeit.