Deepseek V3.1 (Bild © Deepseek)

Deepseek V3.1 (Bild © Deepseek)

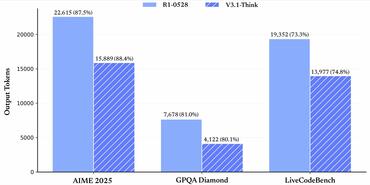

Erste öffentliche Tests zeigen, dass Deepseek V3.1 zu den derzeit schnellsten Vertretern der offenen KI-Forschung gehört. Beim Aider-Coding-Benchmark erreichte das Modell 71,6 %. Es ist ein Ergebnis, das es mit den stärksten allgemein verfügbaren Modellen einreiht. Deepseek V3.1 unterstützt außerdem ein Kontextfenster mit 128.000 Token, so dass auch lange technische Dokumente, Codebasen oder Arbeitslasten mit mehreren Dokumenten verarbeitet werden können, wobei die Reaktionszeit zur Laufzeit im Vergleich zu kommerziellen Anbietern als konkurrenzfähig beschrieben wird.

Zwei Modi für unterschiedliche Workloads

Deepseek unterteilt die Nutzung in zwei verschiedene Laufzeitprofile:

- Deepseek-Reasoner („Think“): optimiert für komplexes, schrittweises Reasoning und mehrstufige Problemlösungen.

- Deepseek-Chat („Non-Think“): abgestimmt auf allgemeine Konversation und alltägliche Aufgaben mit schnellerer Bearbeitungszeit.

Beide Modi behalten die 128k-Kontext-Kapazität bei, so dass Unternehmen zwischen Tiefe und Geschwindigkeit wechseln können, ohne auf die Fähigkeit zu langen Kontexten verzichten zu müssen.

Die Kompromisse sind erheblich. Mit rund 700 GB für die Modellgewichte benötigt Deepseek V3.1 High-End-Beschleuniger, viel VRAM und eine hohe Speicherbandbreite, um den angekündigten Durchsatz zu erreichen. Teams, die eine Einführung erwägen, sollten Ausgaben für die Infrastruktur, optimierte Inferenzstacks, Sharding und möglicherweise Quantisierung einplanen, um Kosten und Latenz auszugleichen.

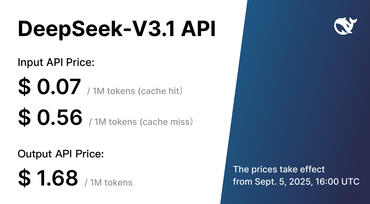

Deepseek LLM-Chat selbst hosten oder nutzen

Potenzielle Nutzer können V3.1 über den browserbasierten Chat von Deepseek ausprobieren. Da der Dienst in China gehostet wird, sollten Tester die Eingabe sensibler Daten vermeiden und ihn eher als Funktionsdemo denn als eine auf Einhaltung der Vorschriften geprüfte Umgebung betrachten. Für den Produktions- oder Forschungseinsatz kann das Modell von Hugging Face selbst gehostet werden.

Open-Source-Strategie und Markt-Timing

Die Veröffentlichung folgt den kürzlichen Markteinführungen von OpenAI und Anthropic, aber Deepseek verfolgt einen anderen Weg: eine offene Verbreitung anstelle von Gated APIs. Dieser Ansatz senkt die Einstiegskosten für Experimente und On-Premise-Einsätze und erweitert den Zugang für Hochschulen und Start-ups, die Wert auf die Verfügbarkeit der Quellen und die lokale Kontrolle legen.